Teil 1: Die Symbiose von Hochleistungs-Hardware und agorum core

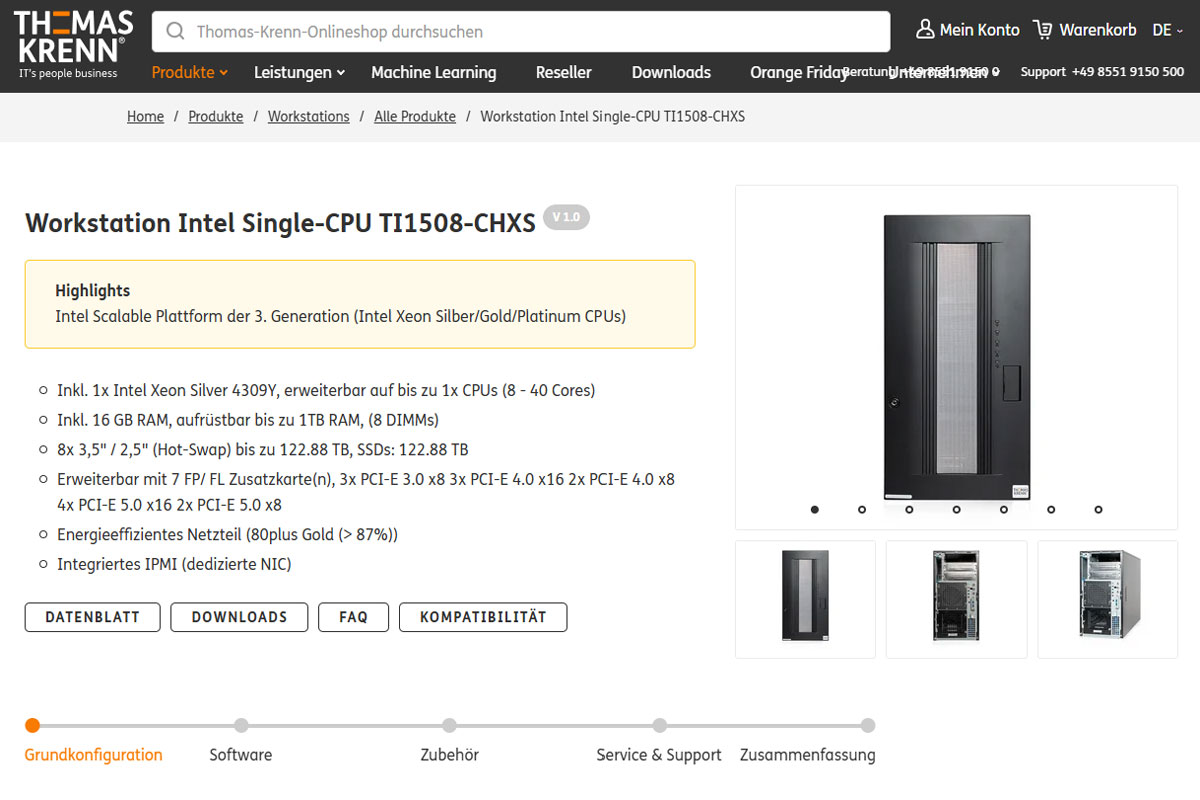

Wir starten einen spannenden Testlauf in der KI-optimierten IT-Infrastruktur. Wir, die agorum Software GmbH, sind stets auf der Suche nach dem nächsten großen Sprung in der Technologie. Diesmal haben wir uns mit einem leistungsstarken KI-Server Workstation Intel Single-CPU TI1508-CHXS der Thomas-Krenn.AG zusammengetan, um die Grenzen dessen auszuloten, was mit agorum core möglich ist. Unsere Mission? Die Verschmelzung von Premium-Hardware und intelligenter Software, um IT-Prozesse auf ein neues Niveau zu heben.

Der Thomas-Krenn KI-Server: Ein Kraftpaket im Datenzentrum

Beginnen wir mit dem Herzstück unserer neuen KI-Initiative: dem Server selbst. Der von der Thomas-Krenn.AG bereitgestellte KI-Server ist ein wahres Kraftpaket, basiert auf der Workstation Intel Single-CPU TI1508-CHXS, die mit einem Intel Xeon Silver 4314 Prozessor (2,40 GHz, 16 Kerne, 24 MB Cache) und 32 GB ECC Registered RAM (1x 32768 MB DDR4 2933) ausgestattet ist. Zudem bietet der Server dank zwei NVIDIA RTX A6000 GPUs mit jeweils 48 GB Speicher eine immense Rechenleistung für anspruchsvolle KI-Modelle, die enorme parallele Verarbeitung und Speicherressourcen benötigen. Als Betriebssystem setzen wir auf Debian Linux Bookworm, das für seine Stabilität und Sicherheit bekannt ist und eine solide Grundlage für KI-Anwendungen bietet.

Die Wahl fiel auf Thomas-Krenn.AG aufgrund ihrer bewährten Zuverlässigkeit und Performance, die wir bereits bei unseren Proxmox-Installationen kennengelernt haben. Mit dieser leistungsstarken Hardware und der flexiblen Linux-Umgebung haben wir eine robuste Basis geschaffen, um selbst komplexeste KI-Projekte effizient umzusetzen.

Erste Schritte: Setup und Integration

Der Startschuss fiel mit der Einrichtung des Servers und der Integration in unsere bestehende Infrastruktur. Unser erster Schritt bestand darin, die notwendige Software-Umgebung zu schaffen. Wir haben uns für Modelle aus der Hugging Face Plattform entschieden, insbesondere für das Llama-3.1-8B-Q4. Die Wahl fiel auf dieses Modell aufgrund seiner herausragenden Balance zwischen Performance und Ressourcenverbrauch.

Technische Details:

- Modellintegration: Die Anbindung erfolgt über die OpenAI API. Hierbei war es entscheidend, die Kontextlänge der Modelle korrekt zu konfigurieren. Modelle mit einer vorab trainierten Kontextlänge sind unerlässlich, da eine nachträgliche Anpassung im Betriebssystem zu unzuverlässigen Ergebnissen führt.

- Performance-Analyse: Wir haben festgestellt, dass die Anzahl der Parameter (z.B. 8B vs. 70B) einen direkten Einfluss auf die Token-Verarbeitungsgeschwindigkeit und den RAM-Verbrauch hat. Während größere Modelle wie 70B auf unserem Setup laufen, sind sie ohne große Kontextfenster aufgrund von GPU-RAM-Beschränkungen nicht praktikabel.

Der Weg zur Automatisierung: Erste Anwendungen

Unser Ziel ist es, den KI-Server als integralen Bestandteil von agorum core zu nutzen, um spezifische Geschäftsprozesse zu automatisieren und zu optimieren. Ein erstes Einsatzszenario ist die automatische Verschlagwortung eingehender E-Mails. Hierbei kategorisiert die Künstliche Intelligenz in agorum core Mails nach Dringlichkeit, Lob, Tadel und Spam. Diese Automatisierung wird durch ein feingetuntes Modell ermöglicht, das speziell auf unsere Anforderungen angepasst ist.

Ein weiteres spannendes Feld ist die Zusammenfassung von Dokumenten. Unsere KI generiert automatisch Kurzfassungen, die als Descriptions auf der externen Website verwendet werden können. Dies spart nicht nur Zeit, sondern erhöht auch die Konsistenz und Qualität der veröffentlichten Inhalte.

Im Zentrum unserer technologischen Fortschritte steht Oliver Schulze. Mit über 35 Jahren Erfahrung in der Programmierung ist er der Mitgründer und Geschäftsführer von agorum Software GmbH. Seine Leidenschaft für Künstliche Intelligenz ist unverkennbar. Seit drei Jahren taucht Oliver tief in die Welt der KI ein, sammelt intensiv Wissen und bringt es direkt in unsere Projekte ein. Er ist nicht einfach nur ein Manager – er ist der Vordenker, der Macher, der unermüdlich daran arbeitet, agorum core kontinuierlich weiterzuentwickeln.

Nun übernimmt Oliver die Leitung unserer Tests mit dem KI-Server von Thomas-Krenn.AG. Seine tiefgreifenden Kenntnisse und sein Gespür für technologische Trends machen ihn zur idealen Person, um das volle Potenzial von Premium-Hardware und intelligenter Software zu nutzen.

Herausforderungen und Lösungen

Die Arbeit mit KI und Hochleistungs-Hardware bringt auch Herausforderungen mit sich. Eine wesentliche Erkenntnis war, dass längere Kontexte in Modellen die Antwortzeiten erheblich verlängern. Um diesem Problem zu begegnen, arbeiten wir an der Optimierung der Modellparameter und der Anpassung der Kontextlänge an die spezifischen Bedürfnisse unserer Anwendungsfälle.

Ein weiterer Punkt ist die Feinabstimmung der Modelle auf spezifische Aufgaben. Unsere anfänglichen Versuche, ein Modell auf Eingangsrechnungen zu feintunen, haben gezeigt, dass dies ein vielversprechender Weg ist, um die Erkennungsgenauigkeit und Effizienz weiter zu steigern.

Zukunftsausblick: Mehr als nur Theorien

Diese Reise steht erst am Anfang. In den kommenden Teilen dieser Blogreihe werden wir tiefer in die spezifischen Einsatzmöglichkeiten eintauchen und unsere Fortschritte dokumentieren. Unser Ziel ist es, mit agorum core und der Unterstützung von Thomas-Krenn.AG eine Vorreiterrolle in der KI-gestützten Prozessautomatisierung einzunehmen.

Bleiben Sie dran, wenn wir in der nächsten Folge über die detaillierten Tests und die ersten produktiven Einsätze berichten. Wir sind begeistert von den Möglichkeiten, die uns dieser KI-Server bietet, und freuen uns darauf, unsere Erkenntnisse mit Ihnen zu teilen. Denn bei agorum gilt: Wir sind nicht nur dabei, wir sind einen Schritt voraus.