Sie arbeiten täglich mit der agorum core Dokumentation, suchen nach Lösungen, schnellem Code-Snippet oder einer präzisen Erklärung? Dann wissen Sie, wie zeitaufwendig es sein kann, sich durch unzählige Seiten zu klicken. Genau deshalb haben wir den nächsten logischen Schritt gemacht: Eine KI-gestützte Suche, die Ihnen sofort die passenden Antworten liefert.

Kein Scrollen, kein Suchen – einfach fragen.

Die Dokumentation von agorum core wächst stetig, was großartig ist, aber auch bedeutet: Ohne effiziente Suchfunktion verliert man schnell wertvolle Zeit. Egal, ob es um Berechtigungen für ein neues Plugin oder eine spezifische JavaScript-Funktion geht – unser neuer KI-gestützter Ansatz nimmt Ihnen diese Arbeit ab.

Warum ist das so leistungsstark?

Das Geheimnis hinter der Präzision unserer KI-Suche heißt Retrieval-Augmented Generation (RAG). Statt nur blind Begriffe zu matchen, kombiniert unser System zwei leistungsstarke Technologien:

- Retrieval (Abruf relevanter Inhalte) – Die KI sucht gezielt nach den 15 relevantesten Doku-Abschnitten.

- Augmented Generation (kontextbasiertes Antworten) – Ein Large Language Model (LLM) formuliert die finale Antwort anhand dieser Abschnitte.

Das Ergebnis? Treffsichere Antworten, direkt aus der agorum core Dokumentation – schnell, präzise und relevant.

Wie funktioniert die KI-Suche?

Wir haben einen Proof of Concept entwickelt, der modernste Technologien mit leistungsstarker Hardware verbindet. Und das steckt dahinter:

- Markdown-Transformation: Die HTML-Dokumentation wurde mit einem Skript in Markdown konvertiert – das ideale Format für eine schnelle Weiterverarbeitung.

- Vektor-Index mit FAISS: Die Dokumentation wurde in 2000-Zeichen-Blöcke unterteilt und als Vektoren gespeichert. So kann die KI blitzschnell relevante Abschnitte finden.

- GPU-Power für Embeddings: Unser Modell sentence-transformers/all-mpnet-base-v2 läuft auf den leistungsfähigen KI-Servern von Thomas-Krenn.AG. Damit erstellen wir extrem präzise Embeddings – schnell und effizient.

- KI-gestütztes Matching: Ihre Frage wird mit Embeddings abgeglichen, die Top 15 relevanten Doku-Abschnitte werden extrahiert und an ein Large Language Model (LLM) übergeben. Das LLM liefert dann eine präzise Antwort – inklusive relevanter Code-Beispiele.

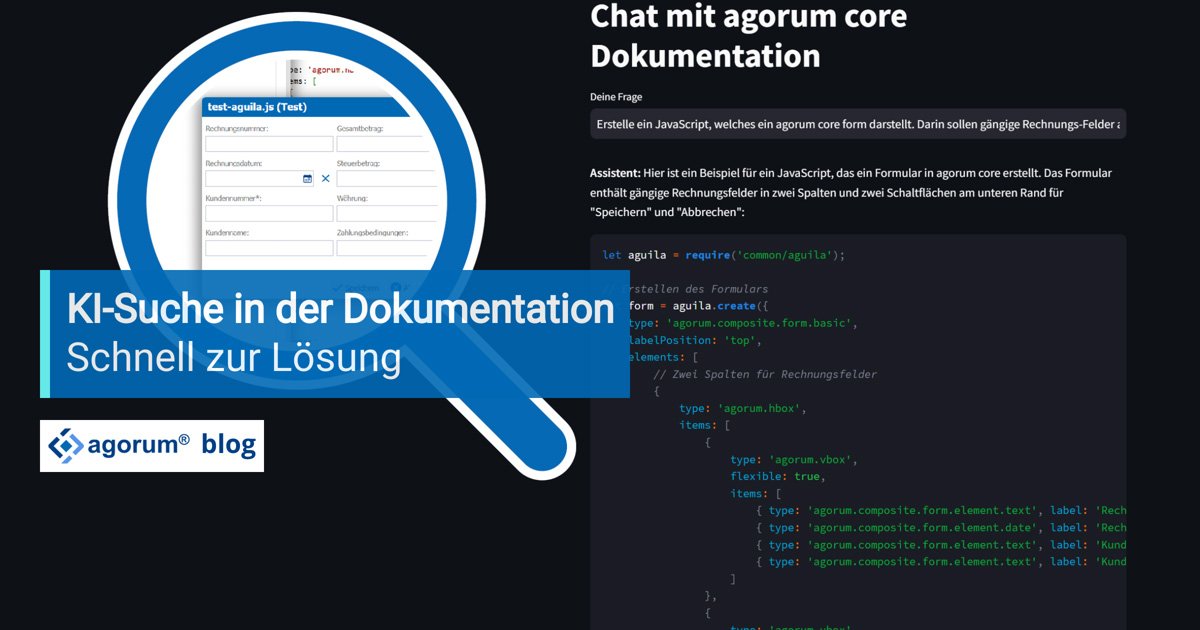

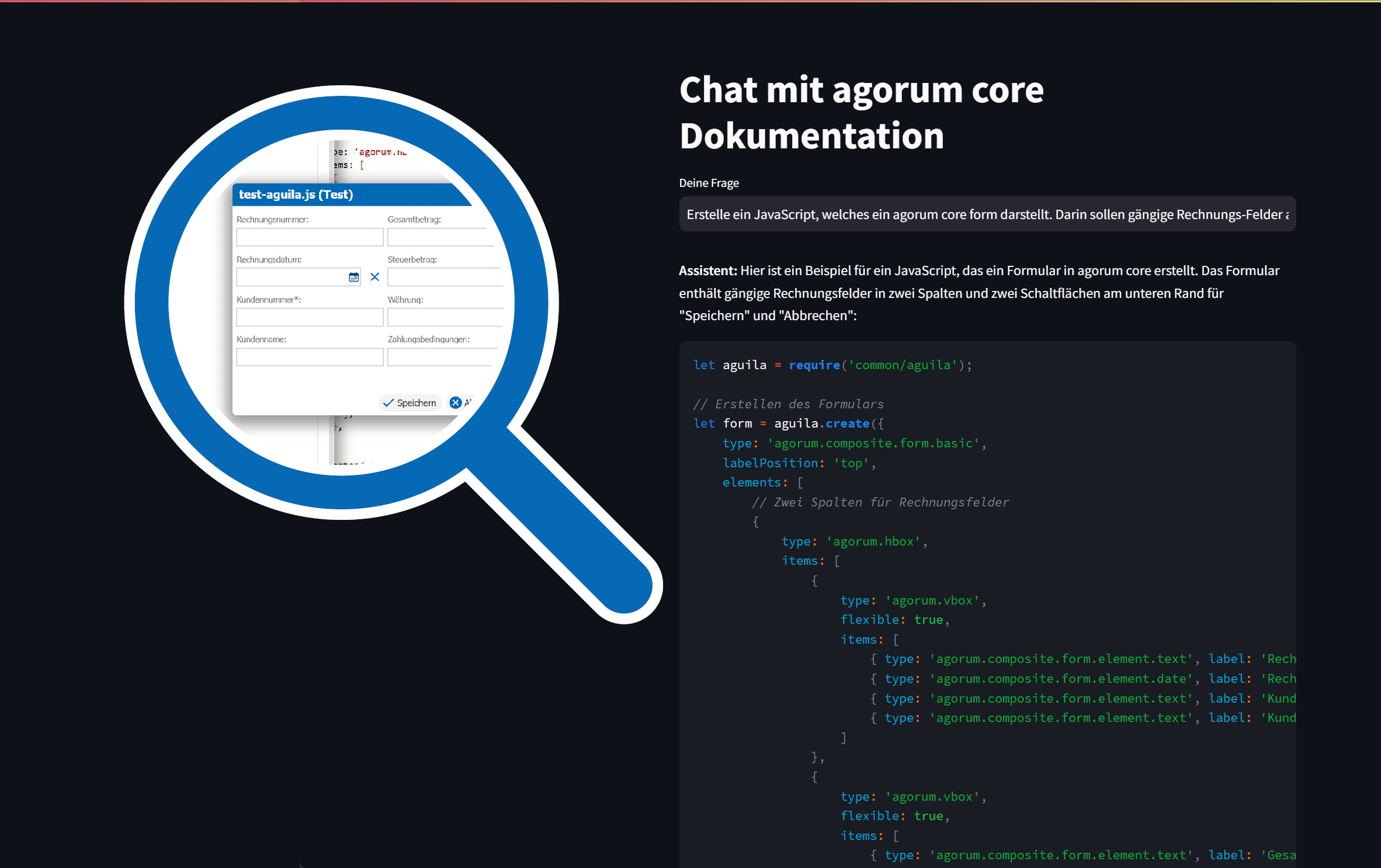

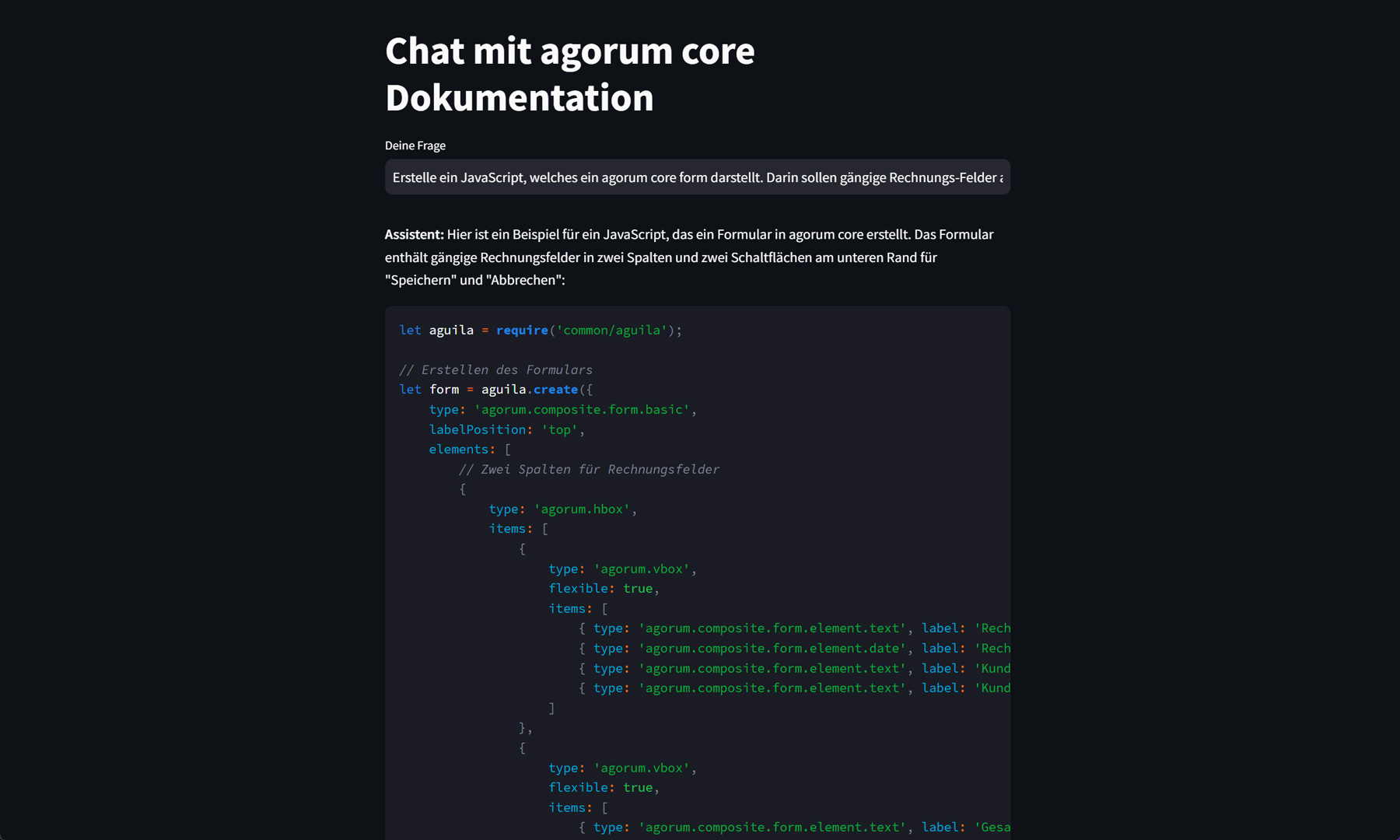

- Einfache Nutzung: Über eine intuitive Streamlit-Web-App können Sie Ihre Frage stellen und direkt die richtige Antwort aus der Dokumentation erhalten.

Warum ist das ein echter Game-Changer?

Diese Lösung geht weit über eine klassische Volltextsuche hinaus:

- Präzise Antworten: Kein Durchforsten von langen Doku-Abschnitten – die KI liefert Ihnen exakt die Information, die Sie brauchen.

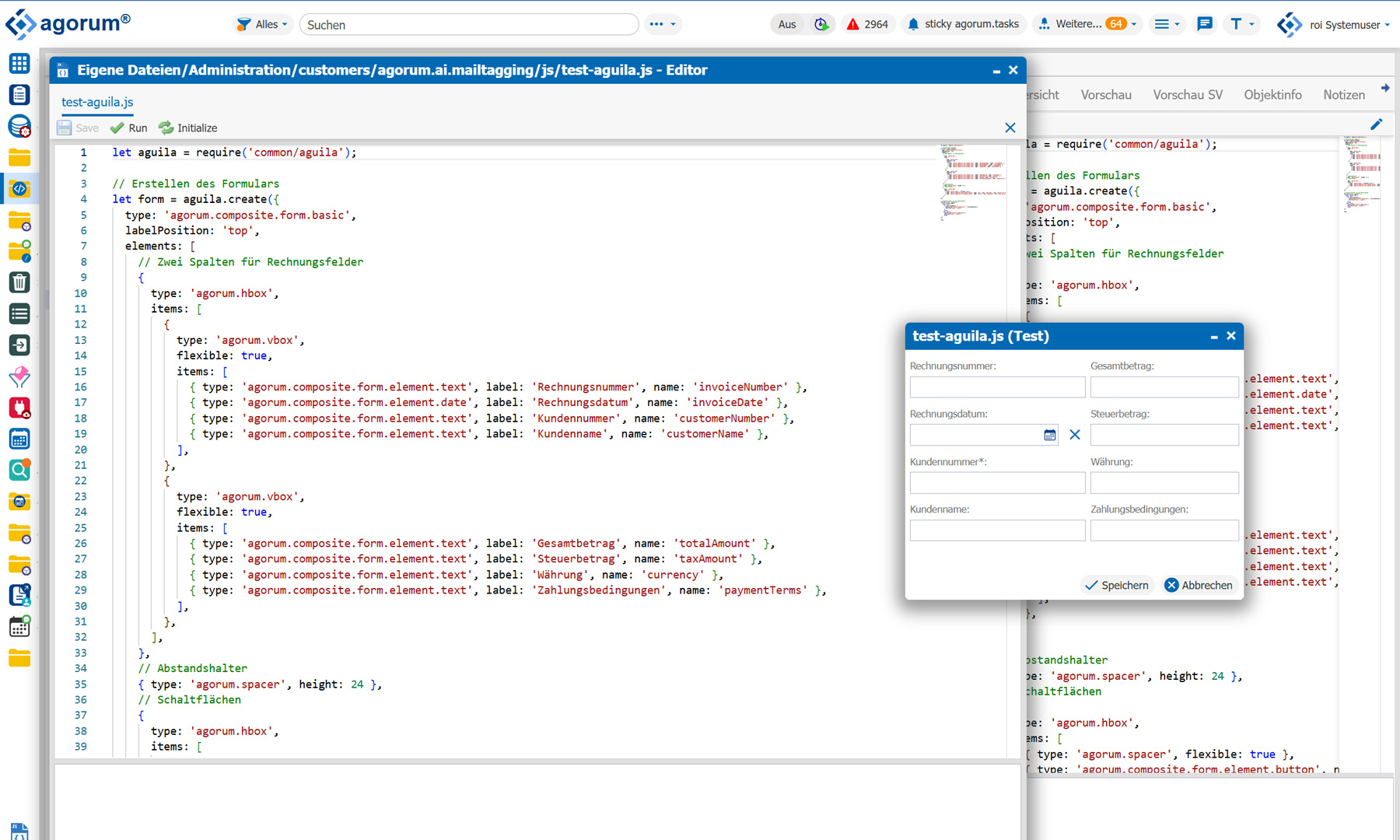

- Code-Generierung: Sie brauchen ein Beispiel? Fragen Sie einfach – und die KI liefert den passenden Code.

- Intuitive Bedienung: Fragen stellen, Antwort erhalten. Kein kompliziertes Interface, keine aufwendige Recherche.

Ein Beispiel: Sie fragen „Wie setze ich Berechtigungen für ein Plugin?“ – Die KI analysiert die Dokumentation, findet die relevanten Abschnitte und gibt Ihnen eine verständliche Antwort. Direkt, ohne Umwege.

Ein weiteres Beispiel für Softwareentwickler

Ich will nicht suchen – ich will Antworten!

Oliver Schulze, Geschäftsführer bei agorum, rät allen Entwicklern, dieses Feature einzusetzen.

"Als Entwickler weiß ich, wie frustrierend es sein kann, Zeit mit der Suche nach der richtigen Info zu verschwenden. Genau deshalb haben wir diese Lösung gebaut: Eine KI-gestützte Suche, die nicht einfach nur Begriffe matcht, sondern echte Antworten liefert – schnell, präzise und direkt aus der agorum core Dokumentation. Kein Suchen, kein Scrollen – einfach fragen und loslegen. Für mich persönlich ist das ein riesiger Effizienzgewinn, den ich nicht mehr missen möchte.“

Oliver Schulze

Warum setzen wir auf die KI-Server von Thomas-Krenn.AG?

Wie schon in unseren ersten Tests hat sich die Hardware von Thomas-Krenn.AG als unschlagbar erwiesen. Die GPUs ermöglichen nicht nur die schnelle Erstellung von Embeddings, sondern sorgen auch für eine extrem effiziente Verarbeitung der Anfragen. Die Kombination aus unserer Software und dieser leistungsstarken Infrastruktur ist der Schlüssel zur blitzschnellen Antwortsuche.

Das ist erst der Anfang

Stellen Sie sich vor, dass jede Frage zur agorum core Dokumentation in Sekundenschnelle beantwortet wird – ohne Suchen, ohne Frustration. Das ist unser Ziel. Und wir denken weiter:

- Erweiterung auf weitere Dokumentationen – so könnten auch andere interne oder kundenspezifische Inhalte durchsuchbar gemacht werden.

- Direkte Verknüpfung mit Support-Ticketsystemen – um automatisch Antworten auf häufige Anfragen zu generieren.

- Individuelle Anpassungen für Unternehmen – damit die KI genau die Antworten liefert, die in Ihrem spezifischen Umfeld benötigt werden.

Wissen auf Abruf – ohne Umwege

Unsere KI-gestützte Suche für die agorum core Dokumentation ist ein echter Schritt in die Zukunft der IT. Schnelle, präzise Antworten statt endloser Sucherei – so geht Effizienz.

Probieren Sie es aus – stellen Sie Ihre erste Frage und erleben Sie, wie agorum core Ihr Wissen smarter macht.